Todos os dias um volume gigantesco de dados é criado e armazenado em servidores pelo mundo. Esses dados podem variar de uma publicação no Facebook até um sensor de telemetria, que falhou e precisa gerar um alerta.

Para lidar com todas essas opções temos a Engenharia de Dados, que é uma área da tecnologia de informação que atua com a coleta, armazenamento e distribuição dos dados. Os Engenheiros de Dados são os profissionais responsáveis por dominar um conjunto de ferramentas e implementarem as soluções necessárias para cada empresa.

Esse artigo, tem o objetivo de abordar algumas das ferramentas do mercado que podem ser utilizadas para construir uma arquitetura de dados organizada, escalável e segura. Então, se você pretende se tornar um Engenheiro de Dados, esse artigo é para você!

Essas são as principais ferramentas para um Engenheiro de Dados:

Python

Python é uma linguagem de programação de alto nível criada por Guido van Rossum em 1991. Por ter uma sintaxe de fácil entendimento e compreensão, ganhou muita popularidade na área de tecnologia sendo utilizada por engenheiros, cientistas de dados, matemáticos e outros profissionais.

Com um grande número de bibliotecas nativas e de terceiros, o Python se adapta aos mais diversos projetos, podendo ser utilizado desde o desenvolvimento de um aplicativo web até o processamento de grandes volumes de dados.

As principais bibliotecas que se destacam na Engenharia de Dados são:

Pandas

Biblioteca para manipulação e análise de dados, perfeita para análises exploratórias, pois em poucos passos conseguimos ler, manipular, agregar e plotar os dados.

Numpy

Biblioteca especializada em cálculos utilizando matrizes em Python, possui diversas funções matemáticas prontas que reduzem o tempo de desenvolvimento e execução do projeto.

Matplotlib e Seabord

Bibliotecas em Python que auxiliam a criação de visões gráficas, no formato de barras, linhas, pizza, entre outros.

Openpyxl

Além do Pandas, a Openpyxml surge como uma alternativa para leitura de arquivos Excel, sendo uma biblioteca desenvolvida especificamente para trabalhar com esse programa.

SQL

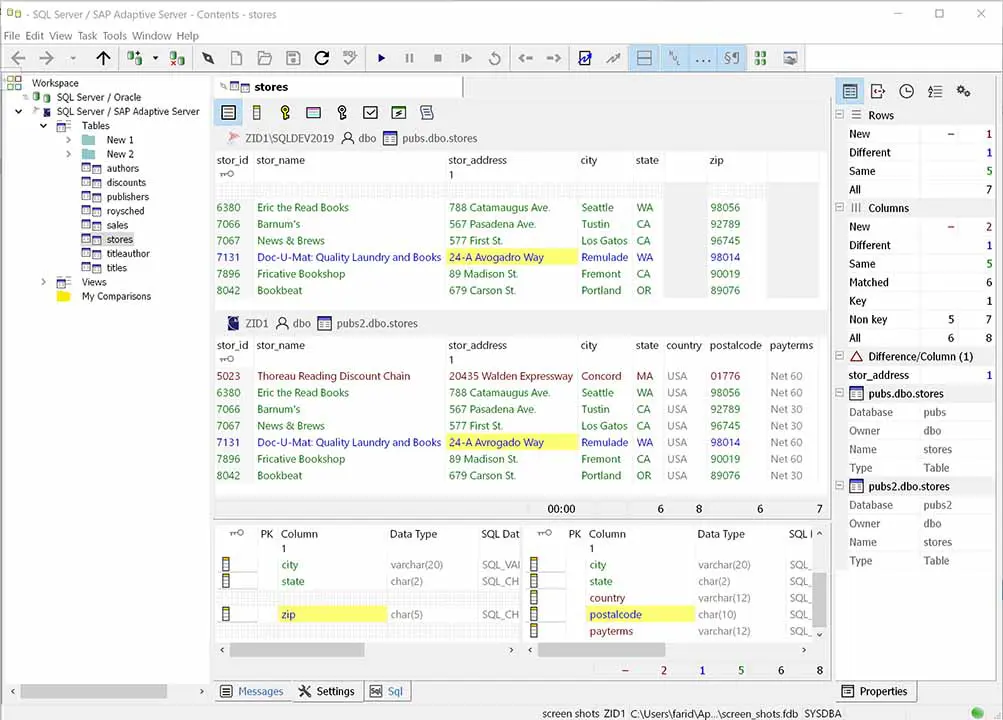

Os bancos de dados relacionais com certeza são umas das fontes mais comuns que os Engenheiros de Dados trabalham. Normalmente deles são extraídas informações gerenciais que estão armazenadas nos sistemas ERP das empresas. Como, por exemplo: Vendas, Compras, Financeiro e Contabilidade.

Por isso, é muito importante que o Engenheiro de Dados conheça a estrutura da linguagem SQL, para conseguir coletar, organizar e consolidar os dados.

As principais tarefas de SQL que o profissional de Engenharia de Dados precisa saber, são:

Conhecer a estrutura base do banco de dados e suas particularidades. Os principais fornecedores do mercado utilizam o padrão SQL ANSI 92, mas, mesmo assim, cada fornecedor implementa algumas funções da sua maneira.

Conseguir criar scripts utilizando a estrutura SQL, que podem ser: Criar Tabelas, Views, Procedures, Funções.

Conhecer a teoria dos conjuntos para conseguir aplicar corretamente as instruções de relacionamento entre tabelas. Por exemplo: Inner Join, Left Join, Right Join ou Cross Join.

Conseguir criar instruções “Selects”, que retornam os dados processados em linhas e colunas, para permitir a criação de análises e relatórios.

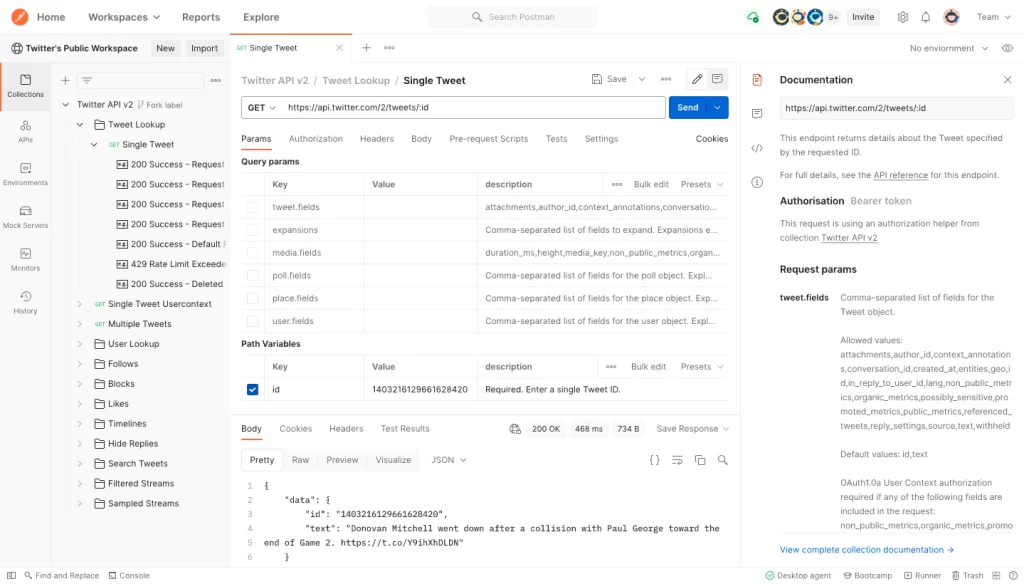

Postman

Muitas vezes precisamos coletar dados de sistemas externos, nesse caso, o Engenheiro de Dados vai precisar construir uma integração com APIs, que retornam muitas vezes os dados no formato REST. Mas, antes de iniciar a construção dos scripts de integração podemos utilizar o Postman para testar e validar as chamadas. Dessa forma, antes mesmo de escrever uma linha de código conseguimos validar se API funciona e se retorna os dados que precisamos.

PySpark

Quando o volume de dados aumenta consideravelmente, precisamos adotar estratégias e ferramentas de Big Data. O Apache Spark é uma das ferramentas que permite o processamento distribuído, com isso, a sua carga de trabalho é “dividida” em diversas máquinas, aumentando a performance e diminuindo o tempo de processamento.

No Python temos uma biblioteca chamada PySpark, que é uma implementação de alto nível para comunicação com os clusters do Apache Spark. Dessa forma, com poucas linhas conseguimos estruturar um código que pode ser executado de maneira distribuída e com alta performance.

A biblioteca PySpark possui uma grande e ativa comunidade, diversos exemplos podem ser encontrados no Github e no seu site https://spark.apache.org/docs/latest/api/python/.

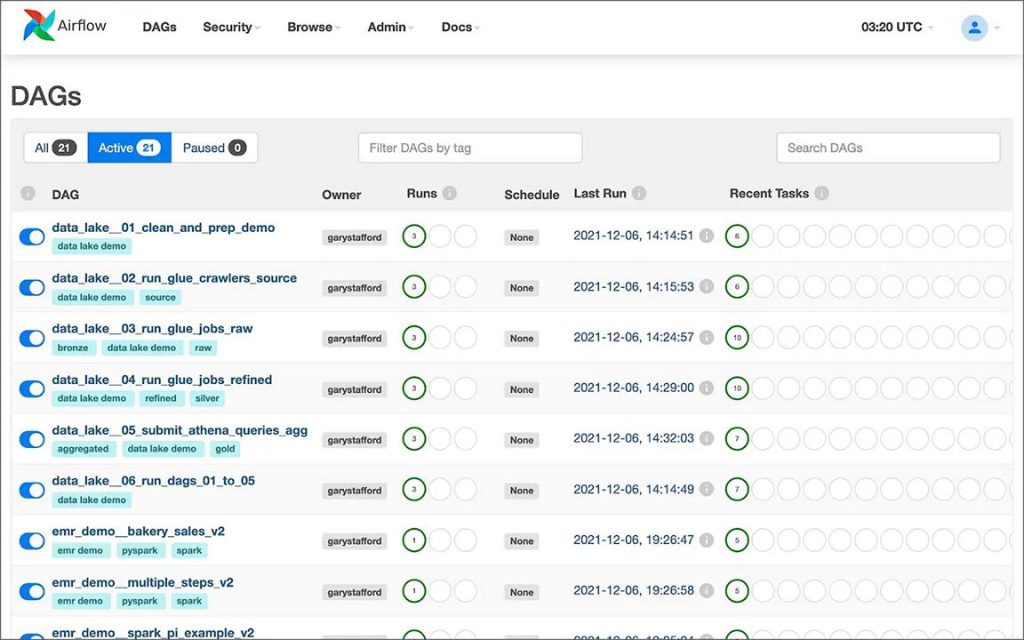

Airflow

O Airflow é uma ferramenta desenvolvida internamente pelos engenheiros de dados do aplicativo Airbnb, em 2016 ele foi incubado pela Apache Foundation e passa a ser conhecido globalmente.

Sua principal característica é possibilitar a criação, agendamento e monitoramento de pipelines de forma programática em Python. Embora existam outras opções no mercado (como Luigi, Prefect, Argo), pode-se dizer que o Airflow se tornou a opção mais adotada para orquestração e agendamento de tarefas.

Aqui estão alguns destaques do Airflow:

Desenvolvimento dos códigos são feitos em Python e com baixo grau de complexidade;

Comunidade grande e com muita documentação;

Facilidade na criação de fluxos simples e complexos de dados;

Interface gráfica para acompanhamento e monitoramento dos Jobs;

Possibilita a criação de componentes personalizados;

Disponibilização de logs para auditoria de erros;

Git

Git é um sistema de controle de versão distribuído open-source (gratuito) muito utilizando no desenvolvimento de software. Ele é um projeto desenvolvido em 2005 por Linus Torvalds, o criador do kernel do Linux.

O principal problema que o Git resolve é o versionamento e controle do código-fonte do seu projeto, dessa forma, com ele é possível ter um histórico de alterações ao longo do tempo, maior segurança, pois o seu código está salvo em um servidor, e melhor controle do seu processo de desenvolvimento de software.

Conhecer o Git é essencial para os profissionais que querem atuar na área de Engenharia de Dados.

Cloud

Por fim, muitas soluções de tecnologia têm sido hospedadas na nuvem, nesse nicho se destacam três players que dominam boa parte do mercado, que são:

AWS – Amazon Web Services;

GCP – Google Cloud Platform

Microsoft Azure – Microsoft

Cada uma possui mais de 200 opções de produtos e serviços que podem ser contratados com poucos cliques, também é possível hospedar seu projeto em diversas regiões pelo mundo, tais como: Ásia, Austrália, Europa, América do Norte e América do Sul.

Alguns dos serviços e recursos disponiveis e que são muito utilizados na Engenharia de Dados:

Construção de Data Lakes;

Computação;

Armazenamento e Banco de Dados;

Análises de Dados;

Internet das Coisas;

Inteligência Artificial.

Com isso, chegamos ao fim do nosso artigo sobre Engenharia de Dados, esperamos que essas informações sejam úteis para quem deseja se tornar um Engenheiro de Dados.

A caminhada é longa e cheia de aprendizados, mas vale muito a pena.

Nesse blog post você viu o poder dessas ferramentas, e é indispensável saber como utilizá-las para extrair o máximo de cada uma. A Qexpert conta com parceiros especialistas, como a Google, Amazon AWS e SAP. E temos um time cheio de experts de alta performance, qualificados e que podem te ajudar com excelência.

Já atuamos com diversas empresas, desenvolvendo soluções únicas para ajudar as organizações a tomarem decisões data-driven e permanecerem relevantes no mercado. Conheça alguns de nossos cases de sucesso.